更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

小红书(https://www.xiaohongshu.com/),号称拥有超过一亿用户的生活方式分享社区,其用户笔记内容涵盖吃穿玩乐买,涉及时尚、护肤、彩妆、美食、旅行、影视、读书、健身等各个生活方式领域,再加上社区每天产生数十亿次的笔记曝光,正如客户所言,其平台是集social和commerce于一体的,其数据价值可想而知。

小红书的数据原本也并不难采集,通过Web版的搜索接口,结合相应的搜索词,就可以搜索到感兴趣的笔记,进而收集到笔记的详情数据。然而好景不长,随着小红书完成了一轮超过 3 亿美元的财务融资,小红书的平台接口也发生了很大的变化:Web版的搜索接口直接关闭,小红书App的应用成为主流。这样一来,之前通过Web版的搜索接口来抓取数据的方法,就直接被封死了。

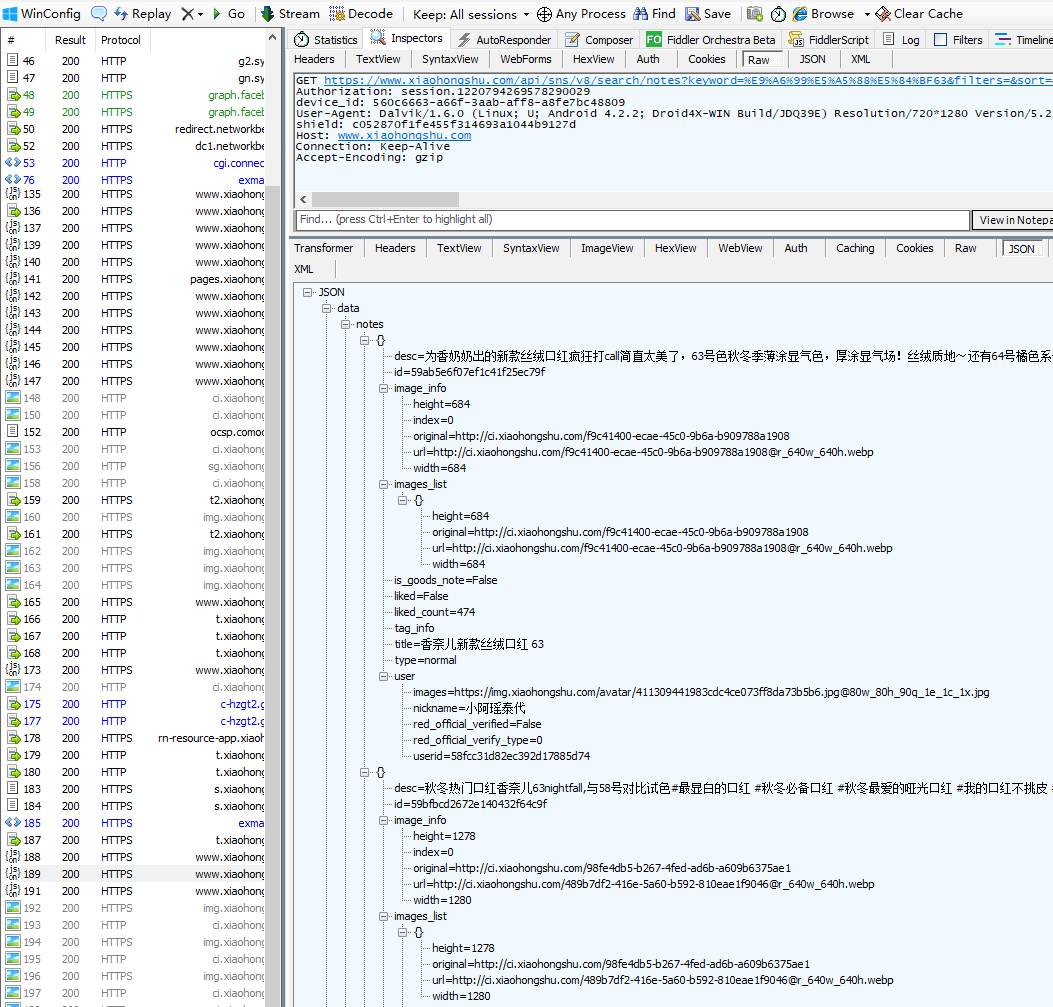

既然Web版的接口不能用了,那就只能看看App的接口了。通过抓包工具,可以获取到小红书App的搜索接口。

这里使用的搜索词是“香奈儿63”,对应的搜索接口URL如下:

可以看到,App接口中的参数很多。然而经过测试,发现这些参数不能修改,改了提交就会失败。而且,这些参数(搜索词keyword除外)也无法自行构造(注意sign参数,这是现在反采集常用的签名保护机制)。看来此路不通啊,抓数之旅再次陷入僵局。

还好,细心的鲲鹏技术人员发现,除了App,小红书还有个微信小程序,于是展开又一轮对小红书微信小程序的分析研究。

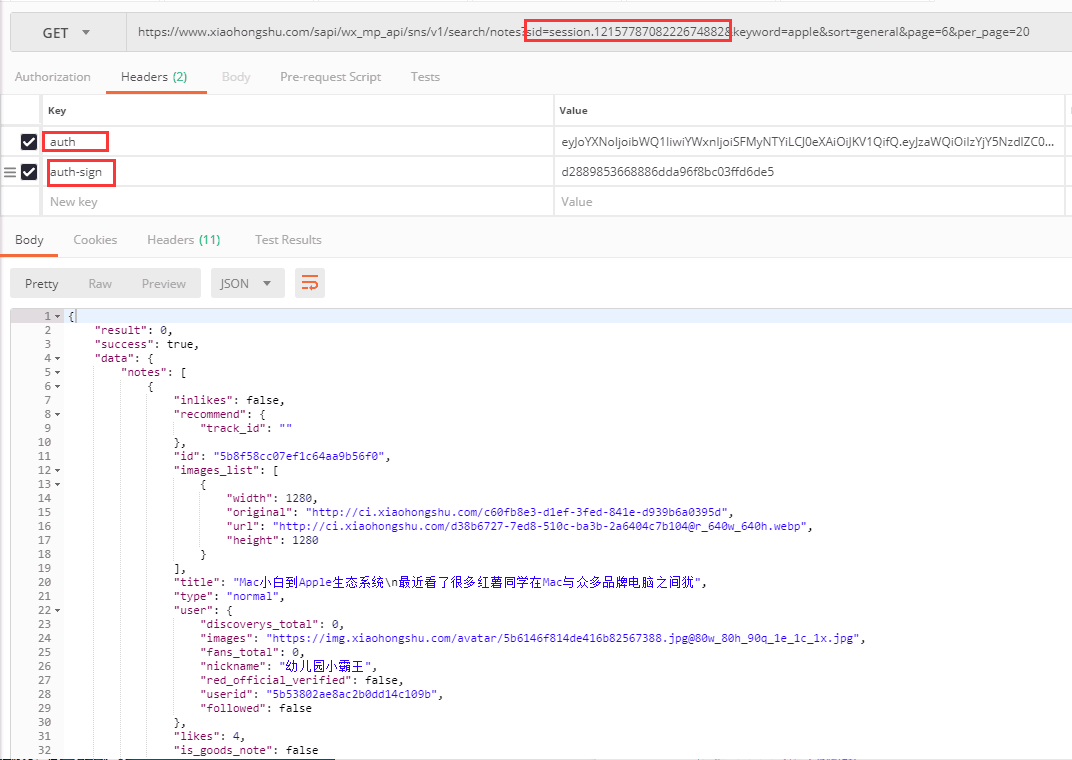

再次抓包分析发现,小红书微信小程序的接口可以修改参数,但是其中三个参数看起来是有有效期的。

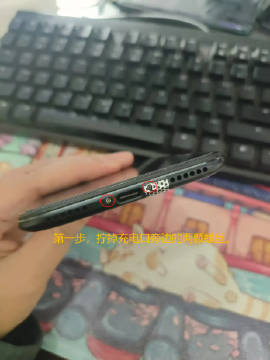

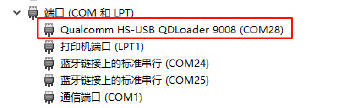

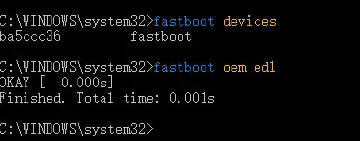

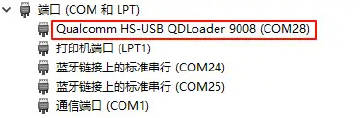

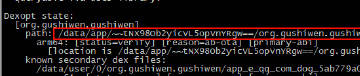

测试发现,只要这三个参数有一定时间的有效期,那就可以在这个有效期内,改变keyword进行搜索,并得到正确的数据。 那么,怎么能第一时间获取到这三个参数呢?鲲鹏技术人员通过研究发现,可以用模拟操作微信小程序的方法,自动操作手机上的小红书小程序,同时用程序自动抓包截取,提取到最新的接口参数以供爬虫使用(如下图所示)。

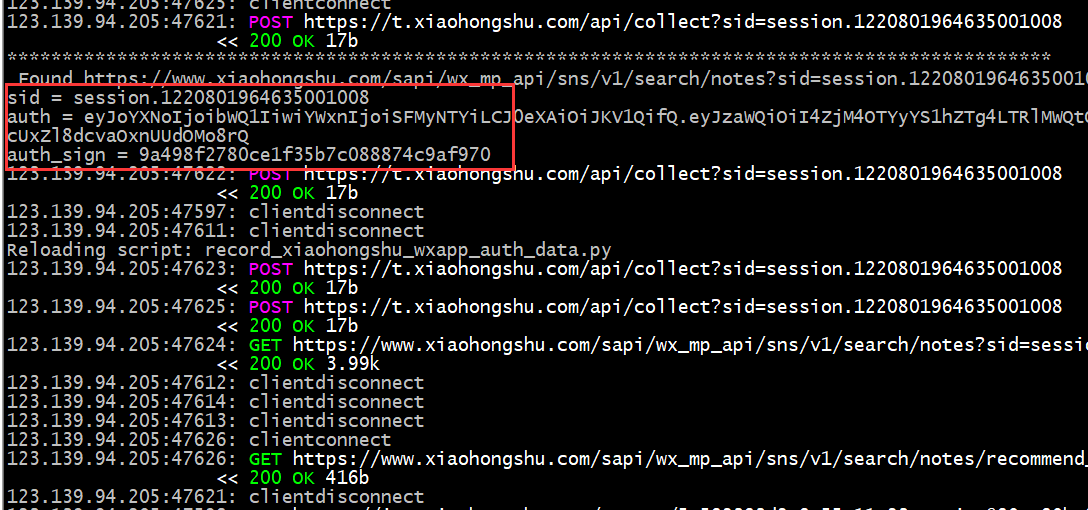

敢想敢为,鲲鹏技术人员积极探索,大胆尝试,克服重重困难,终把想法变成了现实。首先通过自动模拟操作程序,操作手机上的小红书小程序,然后抓包提取到最新的接口参数;接下来使用获取到的接口参数,结合搜索词执行搜索,并收集搜索结果中的笔记相关数据;最后进入笔记详情页,提取所有需要的相关数据。大功告成!

附:

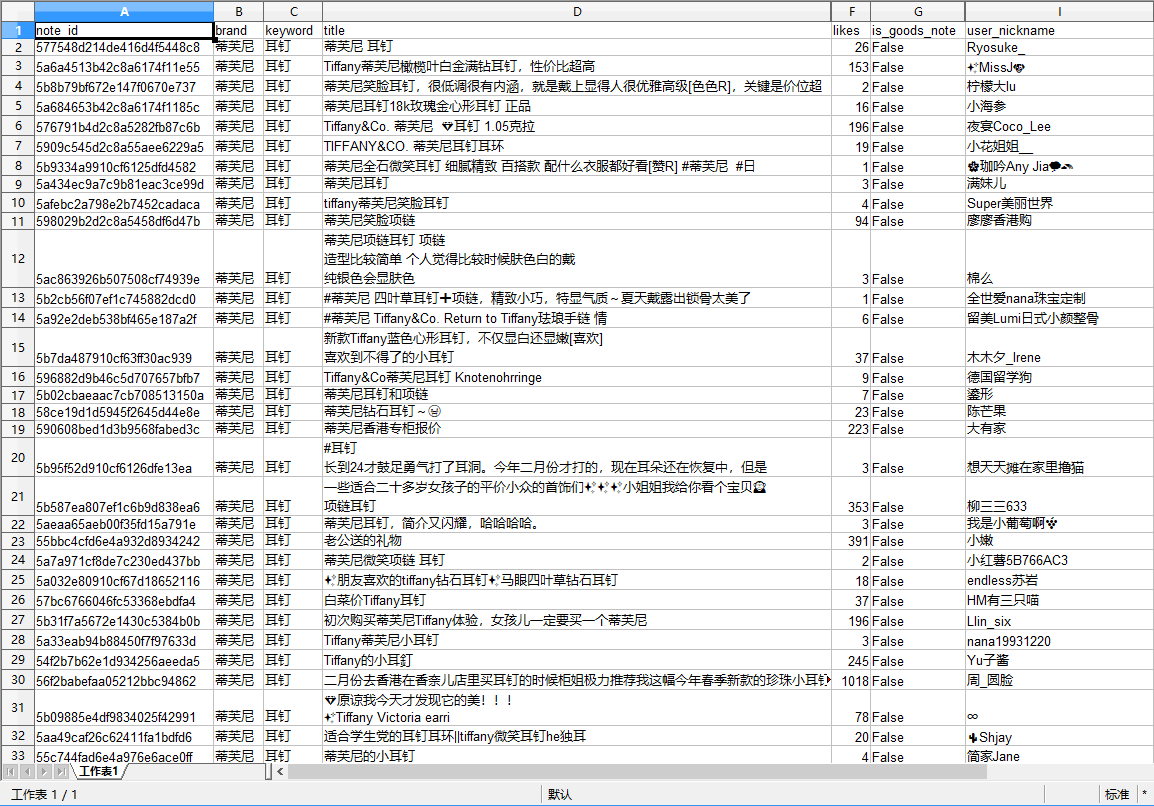

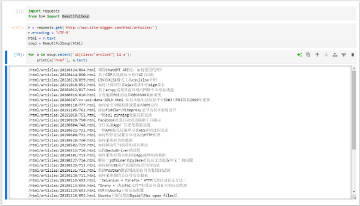

通过小红书微信小程序接口抓取到的搜索结果数据(部分字段)示例如下图: