更多>>关于我们

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

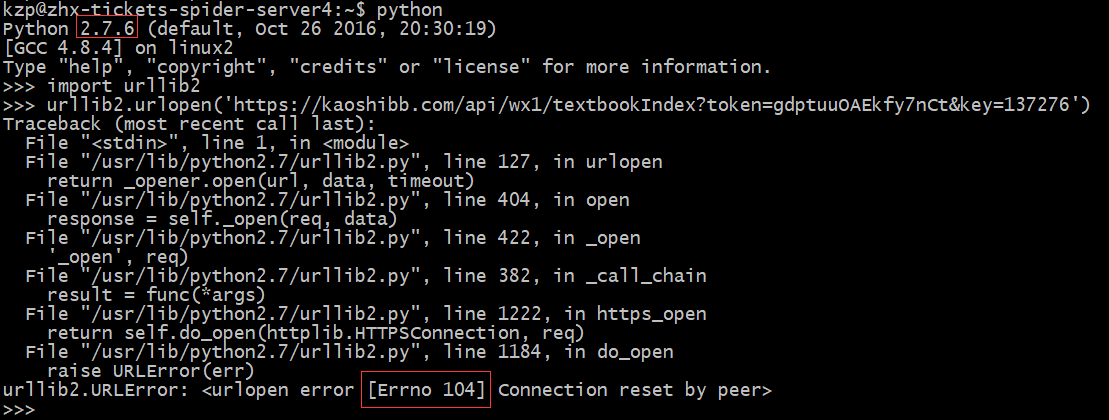

近日我司技术人员在爬取一HTTPS网站(网址为:https://kaoshibb.com/)时遇到了一个奇怪的问题,在相同环境下,获取别的HTTPS URL正常,但是获取该网站URL(e.g. https://kaoshibb.com/api/wx1/textbookIndex?token=gdptuuOAEkfy7nCt&key=137276 )时,却始终返回Errno 104错误。如下图所示,是用urllib2测试的结果(测试环境:系统版本 - Ubuntu 14.04, Python版本 - 2.7.6 )。

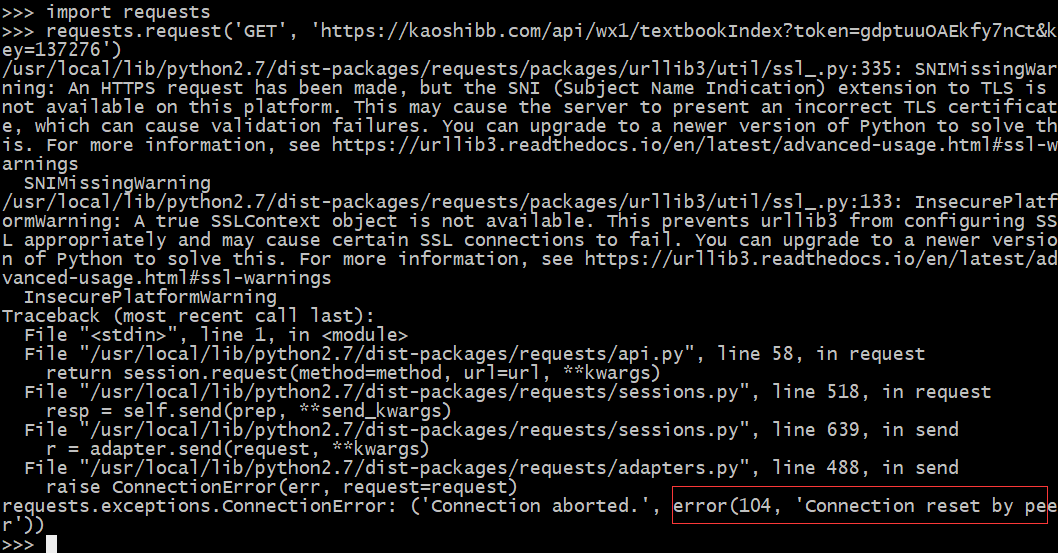

换用requests库测试,问题依旧(也是104错误),如下图所示。

起初怀疑是由于该网站SSL仅支持TLSv1引起的(以前曾遇到过这种问题),之前我们曾介绍过“Python中连接HTTPS网站如何强制使用TLSv1协议”(http://www.site-digger.com/html/articles/20151117/105.html)解决方案,但是测试该方案问题依旧。

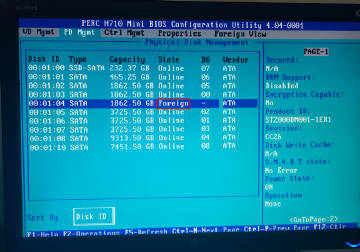

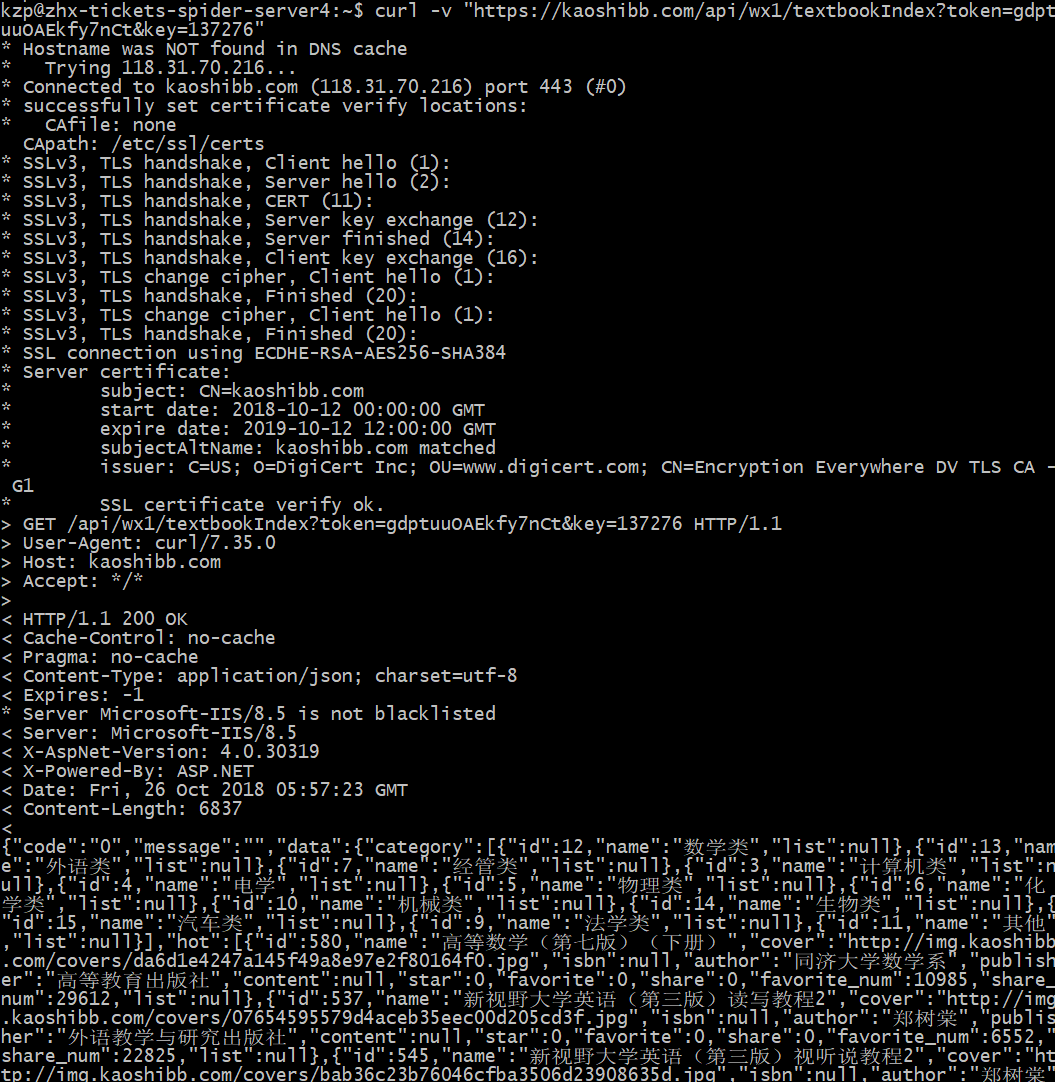

奇怪的是使用curl却可以正确拿到数据,测试(curl -v "https://kaoshibb.com/api/wx1/textbookIndex?token=gdptuuOAEkfy7nCt&key=137276")如下图所示。开始怀疑难道是Python的Bug?!

换用openssl测试(openssl s_client -connect kaoshibb.com:443),依然是返回104错误,如下所示:

~$ openssl s_client -connect kaoshibb.com:443 CONNECTED(00000003) write:errno=104 --- no peer certificate available --- No client certificate CA names sent --- SSL handshake has read 0 bytes and written 295 bytes --- New, (NONE), Cipher is (NONE) Secure Renegotiation IS NOT supported Compression: NONE Expansion: NONE ---

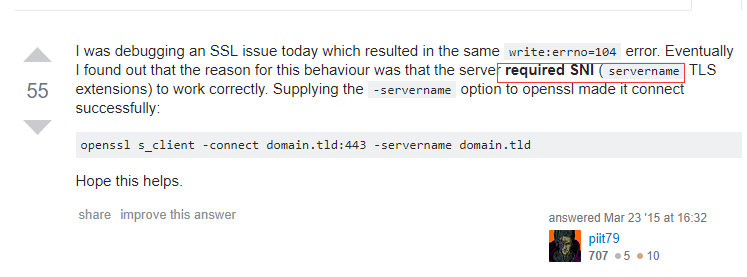

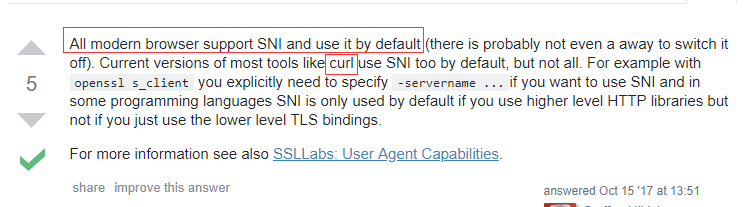

在Stackoverflow搜索“openssl error=104”,看到有人遇到类似的情况,并告知通过添加SNI可以解决问题(https://stackoverflow.com/questions/24457408/openssl-command-to-check-if-a-server-is-presenting-a-certificate 如下图所示)。

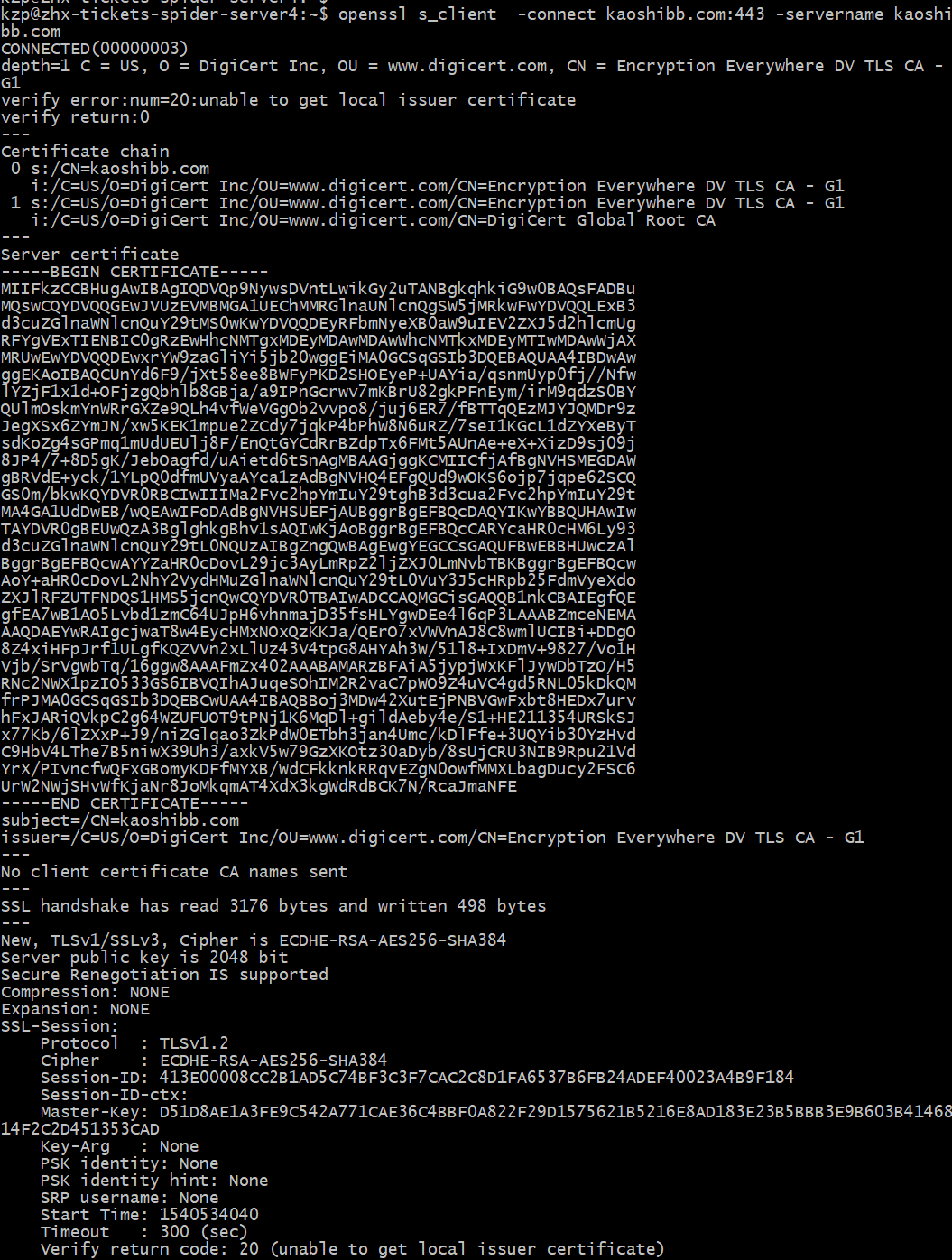

于是乎加上-servername kaoshibb.com参数再次测试(完整命令:openssl s_client -connect kaoshibb.com:443 -servername kaoshibb.com),这次成功建立了TLS连接,没有再出现104错误。

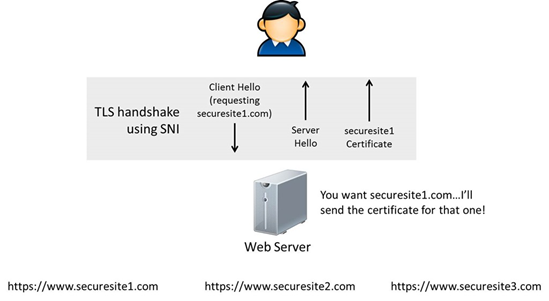

看来,就是因为缺少这个SNI引起的。什么是SNI (Server Name Indication)呢?这里解释的比较清楚(https://cheapsslsecurity.com/blog/simplified-what-is-sni-server-name-indication-how-does-it-work/),有了SNI的存在,使得在同一个IP地址和TCP端口(443)下,能够同时支持多个HTTPS网站,而且每个网站使用不同的证书(想象下两个HTTPS网站架设在同一个服务器的场景),即“一个IP多个证书”。客户端通过SNI告知服务器端要与哪个虚拟主机建立加密连接。

那curl为什么能正常呢?难道是因为它会自动添加SNI(servername)? 搜索“curl tls SNI”找到了答案(https://security.stackexchange.com/questions/171314/do-browsers-and-tools-send-sni-field-by-default-connecting-to-https-endpoints),果然如此:”curl和现在的浏览器都支持并默认使用SNI“。

PS:另据资料显示(https://stackoverflow.com/questions/12941703/use-curl-with-sni-server-name-indication),curl 7.18.1 & OpenSSL 0.9.8 及其以上版本才支持SNI,我测试的环境下curl版本为7.35.0。

现在再回到一开始的问题上,python urllib2 与 kaoshibb.com:443建立TLS连接出现104错误。现在可以推测,应该也是urllib2不支持SNI造成的。谷歌”python urllib2 sni“找到Python issue5639(https://bugs.python.org/issue5639),阅后得知pep-466(https://www.python.org/dev/peps/pep-0466/ PEP 466 -- Network Security Enhancements for Python 2.7.x)已经修复了这个问题。

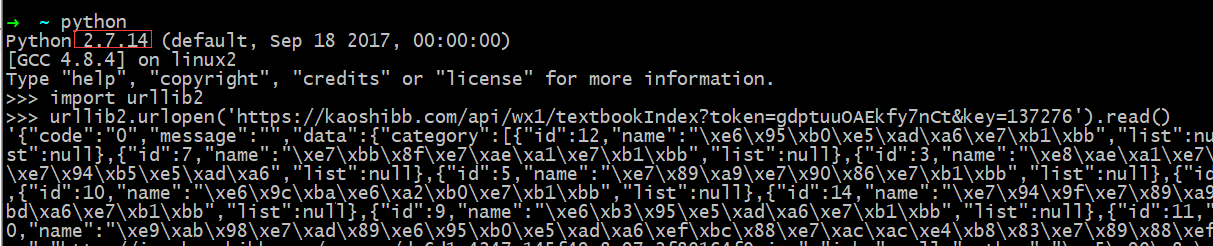

既然知道了这是Python的Bug,并且后续版本已经修复了这个问题,那就好办了,果断升级到最新的Python 2.7.14版本,问题解决。

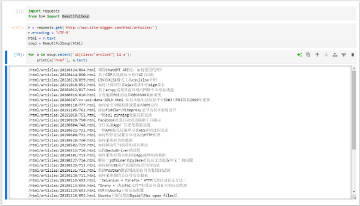

再次测试,结果如下:

还有一个问题,为什么老版本的Python urllib2访问其它HTTPS网站都是正常的呢?一个巴掌拍不响,大多数SSL服务端是不会验证SNI的(一个IP一个证书情况下服务端没必要开启SNI),所以即便客户端没有发拍不响I也能正常建立TLS连接。碰巧遇到这个网站(https://kaoshibb.com/)验证SNI而客户端(Python2.1.6 ssl)恰巧不支持SNI。