更多>>关于我们

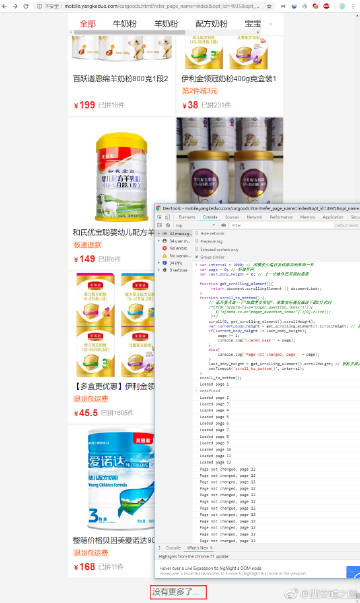

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

西安鲲之鹏网络信息技术有限公司从2010年开始专注于Web(网站)数据抓取领域。致力于为广大中国客户提供准确、快捷的数据采集相关服务。我们采用分布式系统架构,日采集网页数千万。我们拥有海量稳定高匿HTTP代理IP地址池,可以有效获取互联网任何公开可见信息。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

您只需告诉我们您想抓取的网站是什么,您感兴趣的字段有哪些,你需要的数据是哪种格式,我们将为您做所有的工作,最后把数据(或程序)交付给你。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

数据的格式可以是CSV、JSON、XML、ACCESS、SQLITE、MSSQL、MYSQL等等。

更多>>技术文章

-

西安鲲之鹏

发布时间:2019-01-03 15:33:16

-

西安鲲之鹏

发布时间:2018-12-13 12:27:42

【赞】pywebview是webview组件的轻量级跨平台原生封装,实现利用Web技术开发GUI应用 >>> 项目主页:http://t.cn/EUJ5Esq

说明文档:http://t.cn/EUJ5Esy

How to build cross platform Desktop GUI based apps with Python and web technologies and frameworks:http://t.cn/EUJ5EsU -

西安鲲之鹏

发布时间:2018-11-16 22:33:11

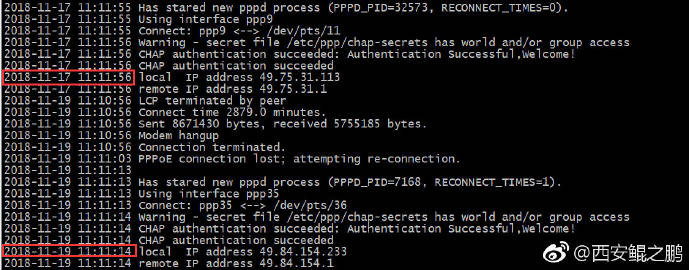

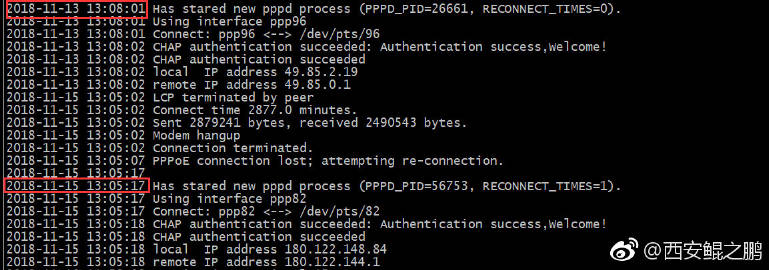

【经验分享】DeleGate有的时候响应速度异常的慢,经查是设计上存在缺陷,修改官方源码,重新编译后问题解决,详见 >>> http://t.cn/E24NJYb

-

西安鲲之鹏

发布时间:2018-11-16 22:31:03

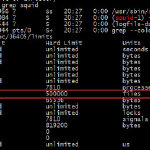

【经验分享】Ubuntu14.04的Squid3.3.8(apt-get安装的官方二进制版本)在编译的时候被加上了 --with-filedescriptors=65536选项。我们从Squid官方下载了3.3.8的源码,重新编译Squid,并将 --with-filedescriptors=65536选项去掉。编译完成后,用新生成的squid二进制文件覆盖原版本squid文件,问题成功解决。查看详情 >>> http://t.cn/E24C6aG

-

西安鲲之鹏

发布时间:2018-11-09 16:58:07

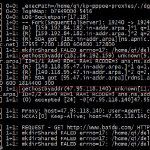

【经验分享】代理服务器出现大量TIME_WAIT怎么破?爬虫客户端用什么库更高效?在本文我们将通过实验给你解答 “与TIME_WAIT相关的一些实验” >>> http://t.cn/EAtquEs -

西安鲲之鹏

发布时间:2018-11-09 16:56:27

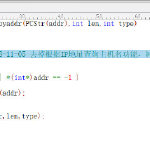

【备忘】mitmproxy v0.18.2版本Python script示例

归纳了一下公司近期常用的mitmproxy Python script编写示例,通过本示例你将学会在mitmproxy中如何通过外挂Python脚本修改请求和应答数据, >>> http://t.cn/EAtq47A -

西安鲲之鹏

发布时间:2018-11-07 14:02:55

【经验分享】自己gcc编译出来的squid可执行程序体积比官方rpm包里的体积大9倍(官方的6MB,自己编译出来的59MB)!使用strip --strip-unneeded file-path 处理之后,体积也变成6MB了!(running strip is a good way to get the size down after you have a binary and the binary is in ELF format. strip just removes debug and unreferenced symbols after the binary has been created.) >>> 参考:http://t.cn/Ews4Fhb -

西安鲲之鹏

发布时间:2018-11-05 13:09:48

-

西安鲲之鹏

发布时间:2018-10-26 18:05:14